根據史丹佛大學「以人為本AI研究中心」(Human-Centered Artificial Intelligence;HAI)所提出的《AI Index 2023》報告,自2017年加拿大正式提出國家AI戰略後,至2022年已有62國相繼提出國家層級的AI戰略。此時期各國AI戰略內容主要朝研發、新創或基礎建設等能力建構,然有鑑於AI爭議事件自2012年以來增加26倍,代表AI濫用的風險日增,也加速AI立法的進行。在報告調查的127國當中,有31個國家在2016年通過AI相關法案,2022年增至123國,顯示全球AI競賽已逐漸轉向為全球AI治理競賽。

AI治理態度 各國大不同

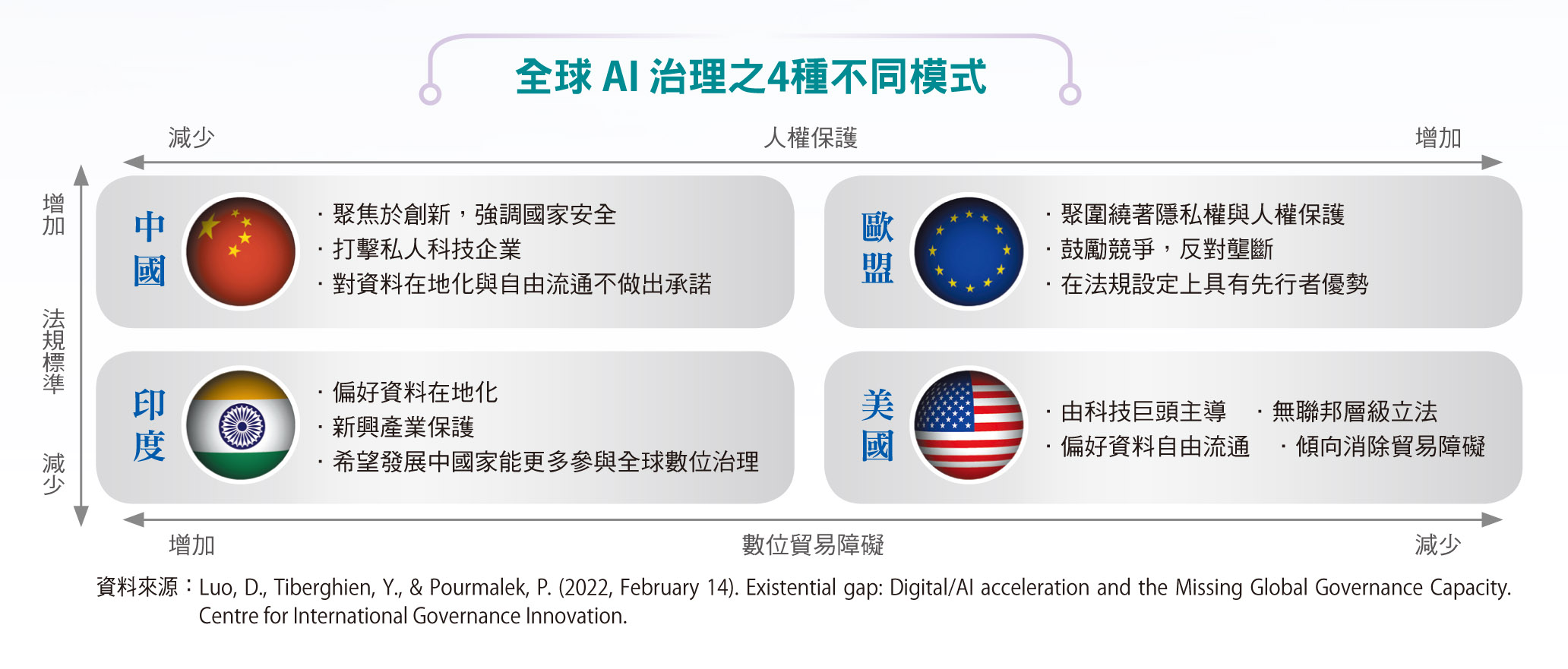

但各國在AI治理的態度歧異相當大,有學者指出美國模式強調創新與有限監管;歐盟模式則強勢主導監管平衡;印度模式強調數位主權與保護新興工業;中國模式則著重強力國家控制與快速創新。這4種模式在法規標準、貿易障礙消除與人權保護上截然不同,造成各國在面對AI發展上的政策與法規作為難有共識,這情形在美中科技與貿易戰、俄烏戰爭後的新地緣政治與國際關係緊張下,更是難以解決。因此,誠如美國前國務卿季辛吉在其書中所表示的,各國在面對數位科技,尤其是AI帶來的社會議題,也必須如淨零排放議題一般,秉持合作精神,從共同利益上找出共識。

AI監管法案 歐盟進度領先全球

目前歐盟對AI的立法進度最積極,根據2020年的Artificial Intelligence and Democratic Values: The AI Social Contract Index指出,全球有數百個AI倫理框架,只有OECD/G20的框架與原則,對各國政策和實踐產生重大影響,現已有超過50個國家政府正式認可OECD/G20原則。

歐盟更是在AI治理上與OECD緊密合作,再加上歐盟的立法舉動向來都帶有「布魯塞爾效應」(Brussel Effect),也就是將歐盟法律透過市場機制外部化去引起監管全球化,甚至進一步控制市場發展趨勢,這也導致2020年歐盟提出AI白皮書時,所有科技巨頭立刻關注其內容,以避免「一般資料保護規定」(GDPR)通過時措手不及。

目前,歐洲議會已通過修正案,力拚年底推出首部AI監管法案。現階段歐洲機構的主要意見包括:將AI系統定義縮小到透過機器學習方法、明確高風險AI系統的要求、釐清AI法的範圍及提出AI監管沙盒等多項措施;在2023年6月14日提出的重點修正項目則包括:修改AI系統定義,將人類監督、技術穩健與安全、隱私與資料治理、透明度、非歧視及社會與環境福祉等6項基本原則納入法案等,更增加對基礎模型的義務要求,將其與高風險AI系統並列,也增加生成式AI的透明度義務。

ChatGPT問世 凸顯立法管理AI發展難題

此次議會修正內容,最受到關注的要屬回應ChatGPT所帶來的衝擊。在 ChatGPT這類生成式AI一夕間席捲全球後,原本歐盟執委會提案的監管邏輯完全無法適用,因為生成式AI未有明確的使用出口,卻會帶來極大衝擊,例如答案的錯誤或偏見、生成內容的偏誤等,應用上存在著許多風險。由此可知,AI技術的快速演變,可能讓前一年才確立的立法原則完全不適用,這也凸顯人類試圖立法管理AI發展的重要難題。

AI治理的落差雖是發展的必然,但卻不能置之不理,許多學者紛紛呼籲,大國必須放下成見,避免AI競賽成為軍備競賽,否則將招致難以想像的後果。另一方面,AI治理的全球層級似乎正由OECD原則與歐盟法案所主導發展。然而,歐盟立法絕非橫空出世,而是在高層級的共識達成後,再逐步的形成法規原則與管制內容等細節,歷時將近3年。我國此前也曾傳出將推動AI基本法的聲浪,雖然後來已確定暫緩,但必須思考的是,我國在AI法制的前置作業是否如同歐盟完整?AI治理與立法雖然是全球趨勢,在考量實際作為時,仍宜審慎觀察整體流程與背景脈絡,方能打造出相對完善且因地制宜的治理法規體系,讓法規不止於宣示意義,還能具體落實。

(本文由工業技術與資訊授權轉載)